Tugas pokok robot web adalah melakukan perayapan atau pemindaian pada situs web dan halaman untuk mengumpulkan informasi. Untuk menggunakannya, kamu perlu tahu cara setting robot TXT.

Robot web beroperasi tanpa henti untuk mengumpulkan data yang mesin pencari dan aplikasi lainnya perlukan. Setelah implementasi, file robots.txt memungkinkan perayap web dan bot mengetahui informasinya.

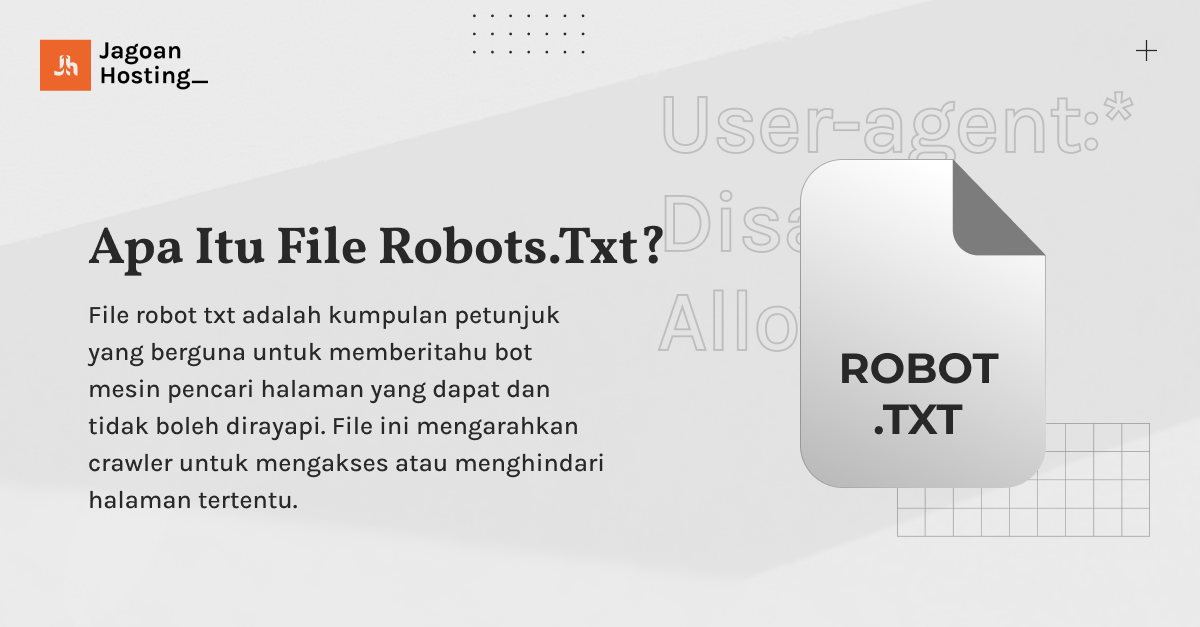

Apa Itu File Robots.txt?

Website Cepat Dimulai dari Hosting yang Tepat!

Memilih Hosting bukan hanya soal kapasitas, tapi juga keandalan. Pelajari cara memilih hosting terbaik yang bisa mendukung pertumbuhan website kamu!Intip Panduannya Sekarang

File robot txt adalah kumpulan petunjuk yang berguna untuk memberitahu bot mesin pencari tentang halaman yang dapat dan tidak boleh dirayapi. File ini mengarahkan crawler untuk mengakses atau menghindari halaman tertentu.

Robots.txt umumnya terletak di root situs web. Sebagai contoh, www.domainkamu.com akan menyertakan file robots.txt di www.domainkamu.com/robots.txt. Dokumen tersebut terdiri dari satu atau lebih peraturan yang mengizinkan atau membatasi akses oleh crawler.

Secara default, semua file diizinkan untuk dirayapi kecuali ada pengecualian yang ditentukan. File robots.txt merupakan elemen awal yang crawler periksa saat menjelajahi sebuah situs.

Situs web seharusnya hanya memiliki satu file robots.txt. File tersebut ada pada halaman tertentu atau seluruh situs untuk mengatur informasi dari mesin pencari tentang situs webmu.

Fungsi dari Robot.txt

File robots.txt memiliki peran penting dalam mengelola aktivitas perayap web. Dengan begitu, situs web tidak terbebani oleh perayapan berlebihan atau mengindeks halaman yang seharusnya tidak perlu. Berikut adalah beberapa fungsi robot txt:

1. Optimalisasi Crawl Budget

Anggaran perayapan mengacu pada jumlah halaman yang akan perlu Google jelajahi di situsmu dalam suatu periode waktu tertentu. Jumlah ini dapat bervariasi tergantung pada ukuran situs dan jumlah backlink.

Jika jumlah halaman di situsmu melebihi anggaran perayapan, kemungkinan besar beberapa halaman tidak akan terindeks Google. Alhasil, halaman yang tidak terindeks tidak akan muncul dalam hasil pencarian.

Penting bagi kamu menggunakan robots.txt untuk memblokir halaman yang tidak perlu. Dengan begitu, Googlebot (crawler web Google) akan menghabiskan lebih banyak anggaran perayapannya pada halaman yang penting saja.

2. Blokir Halaman Duplikat dan Non-Publik

Bot perayap tidak perlu mengindeks setiap halaman di situsmu, terutama yang tidak untuk dipublikasikan dalam hasil pencarian. Beberapa sistem manajemen konten contohnya WordPress, secara otomatis melarang akses crawler ke halaman login (/wp-admin/).

Dengan menggunakan robots.txt, kamu bisa dengan mudah memblokir akses crawler ke halaman-halaman tersebut.

3. Menyembunyikan Resources

Ada situasi ketika kamu ingin mencegah indeksasi resources seperti PDF, video, dan gambar dalam hasil pencarian. Hal ini bertujuan untuk menjaga kerahasiaan atau memastikan fokus Google pada konten yang lebih penting.

Dengan menggunakan robot txt generator, kamu bisa mengatur agar resources tersebut tidak tampil karena tidak terindeks.

Pada intinya, robots.txt memungkinkan data pada situs terlindungi. Kamu bisa memilih halaman yang tidak ingin terindeks sehingga bisa mengoptimasi halaman-halaman penting saja.

4. Mencegah Tampilnya Konten Duplikat di SERP

File robots.txt dapat membantu mencegah konten ganda muncul dalam hasil mesin pencari (SERP). Meskipun perlu kamu ingat bahwa penggunaan meta tag robot sering menjadi pilihan yang lebih efektif.

5. Menjaga Privasi Bagian Tertentu dari Situs

File robots.txt berguna untuk menjaga beberapa area situs. Misalnya bagian pengembangan atau staging agar tetap tetap dan tidak terkena oleh perayapan mesin telusur.

6. Menentukan Lokasi Peta Situs

File ini berguna untuk menunjukkan lokasi sitemap di situs web. Alhasil bisa memberikan panduan yang jelas kepada mesin telusur.

7. Menentukan Penundaan Crawling

File ini memungkinkanmu untuk menetapkan penundaan perayapan. Dengan begitu, dapat membantu mencegah beban berlebih pada server saat perayap mencoba memuat banyak konten sekaligus.

Bagaimana File Robots.txt Bekerja?

Cara setting robot txt berfungsi sebagai panduan bagi bot mesin pencari mengenai URL mana yang bisa tampil dan mana yang tidak perlu.

Mesin pencari seperti Google memiliki dua tujuan utama. Pertama yaitu menjelajahi web untuk menemukan konten. Lalu mengindeks serta menyajikan konten kepada pencari yang mencari informasi.

Ketika bot mesin pencari menjelajahi situs web, search engine itu mengikuti tautan dari satu situs ke situs lainnya melalui jutaan link, halaman, dan situs web. Namun, sebelum melakukan tindakan lain, bot akan memeriksa file robots.txt jika ada.

Aturannya yaitu mengidentifikasi bot mesin pencari. Lalu, ada arahan (aturan). Pada aturan seperti ini terdapat pengganti tanda bintang (*) sehingga mengaplikasikan aturan untuk semua bot.

Meskipun file robots.txt memberi instruksi, file itu tidak memiliki kemampuan untuk menegakkan aturan. File tersebut lebih seperti kode etik. Bot yang bertindak dengan baik akan mematuhi aturan, tetapi bot seperti bot spam, dapat mengabaikannya.

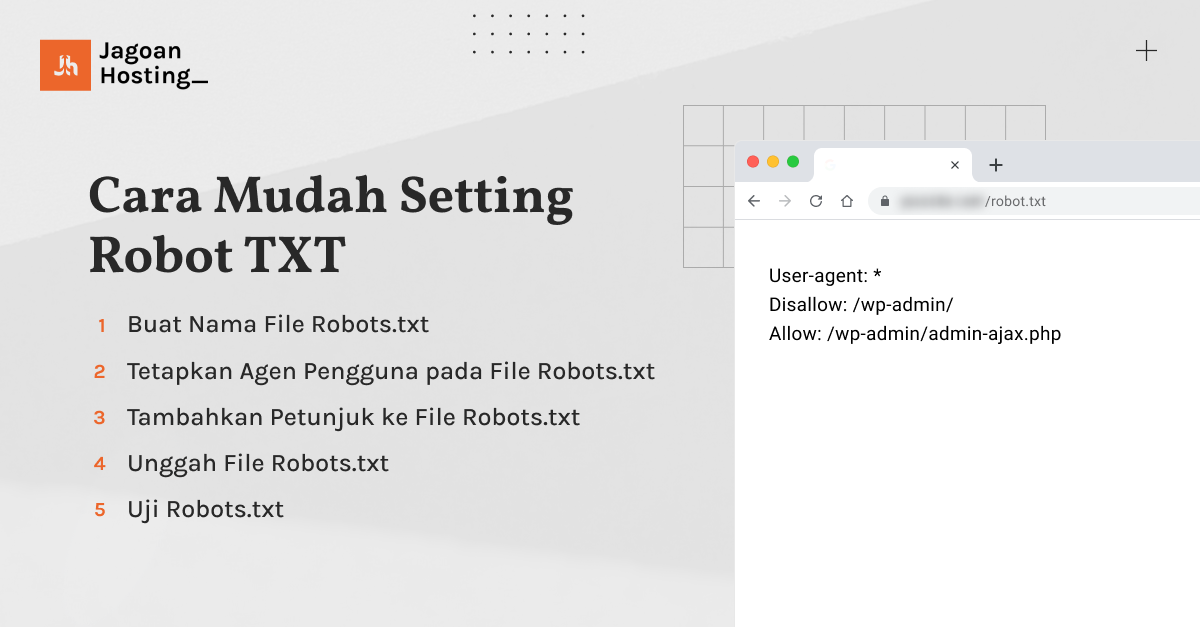

Cara Setting Robot txt

Untuk membuat file robots.txt, kamu bisa memakai alat generator robots.txt atau membuatnya secara manual. Berikut langkah-langkahnya:

1. Buat Nama File Robots.txt

Untuk membuat robot txt, mulailah dengan membuka dokumen .txt. Kamu bisa menggunakan editor teks atau browser web.

Pastikan tidak memakai pengolah kata karena aplikasi pengolah kata sering menyimpan file dalam format eksklusif yang dapat menambahkan karakter acak. Selanjutnya, beri nama dokumen tersebut robots.txt.

2. Tetapkan Agen Pengguna pada File Robots.txt

Langkah selanjutnya adalah menetapkan user-agent yang berkaitan dengan perayap atau mesin telusur yang ingin kamu izinkan atau blokir. Ada tiga cara berbeda untuk mengonfigurasi agen pengguna:

- Membuat Satu Agen Pengguna:

Contoh cara mengatur user-agent

User-agent: DuckDuckBot

- Membuat Lebih dari Satu Agen Pengguna:

Contoh cara mengatur lebih dari satu user-agent

User-agent: DuckDuckBot

User-agent: Facebot

- Menetapkan Semua Perayap sebagai Agen Pengguna:

Contoh cara mengatur semua crawler sebagai user-agent

User-agent: *

3. Tambahkan Petunjuk ke File Robots.txt

File robots.txt terdiri dari satu atau lebih grup arahan. Setiap grup terdiri dari beberapa baris instruksi. Setiap grup dimulai dengan “agen-pengguna” dan mencakup informasi tentang agen pengguna, direktori yang dapat diakses dan tidak dapat diakses, serta peta situs (opsional).

File robots.txt dibaca dalam kelompok yang mana setiap kelompok menentukan aturan untuk satu atau beberapa agen pengguna. Berikut aturannya.

- Disallow: Menentukan halaman atau direktori yang tidak diizinkan untuk dirayapi oleh agen pengguna tertentu.

- Allow: Menentukan halaman atau direktori yang diizinkan untuk dirayapi oleh agen pengguna tertentu.

- Sitemap: Memberikan lokasi peta situs untuk situs web.

Mengatur Robot TXT untuk mengizinkan mengakses semua halaman:

User-agent: * Allow: /

Untuk menghindari Google merayapi direktori /clients/, kamu bisa membuat grup arahan pertama dengan setting robot txt blogger sebagai berikut:

User-agent: Googlebot

Disallow: /clients/

Lalu kamu bisa menambahkan instruksi tambahan pada baris berikutnya seperti:

User-agent: Googlebot

Disallow: /clients/

Disallow: /not-for-google

Setelah selesai dengan cara setting robot txt di wordpress memakai instruksi spesifik untuk Googlebot, buat grup arahan baru.

Grup ini untuk semua mesin pencari dan hindari search engine itu untuk merayapi direktori /archive/ dan /support/:

User-agent: Googlebot

Disallow: /clients/

Disallow: /not-for-google

User-agent: *

Disallow: /archive/

Disallow: /support/

Setelah menyelesaikan arahan, tambahkan peta situs:

User-agent: Googlebot

Disallow: /clients/

Disallow: /not-for-google

User-agent: *

Disallow: /archive/

Disallow: /support/

Sitemap: https://www.yourwebsite.com/sitemap.xml

4. Unggah File Robots.txt

Setelah menyimpan file robots.txt, unggah file tersebut ke situs web milikmu agar mesin pencari bisa mengaksesnya. Cara memasang robot txt dan mengunggahnya tergantung pada struktur file situs dan penyedia hostingmu.

5. Uji Robots.txt

Ada beberapa cara untuk menguji dan memastikan bahwa file robots.txt kamu berfungsi dengan benar. Contohnya yaitu menggunakan penguji robots.txt di Search Console Google atau alat pengujian seperti Validator robots.txt dari Merkle, Inc. atau alat Uji robots.txt dari Ryte.

Melalui alat-alat ini, kamu dapat mengidentifikasi dan memperbaiki kesalahan sintaksis atau logika yang mungkin ada dalam file robots.txt.

Uji apakah file robots.txt dapat diakses secara publik dengan membuka jendela pribadi di browser dan mencari file tersebut. Misalnya, https://www.domainkamu.com/robots.txt. Pastikan untuk memverifikasi kemampuan mesin pencari membaca file ini.

Selanjutnya, uji file robots.txt menggunakan Penguji robots.txt di Google Search Console. Pilih properti yang sesuai dengan situsmu. Dengan begitu akhirnya alat ini akan mengidentifikasi peringatan atau kesalahan sintaksis.

Perhatikan bahwa perubahan pada alat ini tidak langsung mempengaruhi situs. Kamu perlu menyalin perubahan ke file robots.txt pada situsmu.

Terakhir, alat Audit bisa membantu memeriksa masalah terkait file robots.txt. Setelah menyiapkan proyek dan mengaudit web, periksa tab “Masalah” dan cari “robots.txt” untuk melihat apakah ada kesalahan.

Nah itu dia cara mengatur file robots.txt yang bisa kamu pahami.

Website Kamu Butuh Hosting Terbaik!

Jangan asal pilih hosting! Pastikan website kamu berjalan cepat, aman, dan tanpa hambatan dengan shared hosting terbaik dari Jagoan HostingCek Tips Memilihnya

Cara Mengoptimasi robots.txt untuk SEO

Setelah tahu cara setting robot txt, kini saatnya kamu mengoptimasi file tersebut. Cara optimalisasi robots.txt terutama bergantung pada jenis konten yang ada di situsmu. Berikut ada beberapa cara umum untuk memanfaatkannya.

Salah satu penggunaan efektif dari file robots.txt adalah untuk memaksimalkan anggaran perayapan mesin telusur. Kamu bisa mengoptimasi robots.txt melalui plugin SEO seperti Yoast, Rankmath, All in One SEO, dan sejenisnya.

Salah satu cara setting robot txt di Yoast atau pun plugin SEO lainnya agar optimal yaitu dengan memberitahu search engine untuk tidak merayapi bagian situs yang tidak ditampilkan ke publik.

Contohnya, kalau kamu melihat website, mesin pencari tidak menampilkan halaman login (wp-admin). Sebab, halaman tersebut hanya untuk mengakses bagian belakang situs, tidak efisien bagi bot mesin telusur untuk merayapinya.

Kamu mungkin bertanya-tanya jenis halaman apa yang harus kamu kecualikan dari indeksasi. Berikut beberapa saran secara umum untuk mengoptimasi halaman robot txt seo.

- Konten duplikat

Dalam beberapa kasus, ada kebutuhan untuk memiliki versi halaman yang ramah printer atau melakukan pengujian terpisah pada halaman dengan konten yang sama. Pada kondisi ini, kamu bisa memberitahu bot untuk tidak merayapi salah satu versi tersebut.

- Halaman terima kasih

Halaman terima kasih bisa kamu akses melalui Google. Dengan kata lain, memblokirnya memastikan hanya prospek yang memenuhi syarat yang dapat melihat halaman tersebut.

- Penggunaan arahan noindex

Tujuannya untuk memastikan bahwa halaman tertentu tidak terindeks. Kemudian gunakan arahan noindex bersamaan dengan perintah pelarangan.

- Arahan nofollow

Tujuannya untuk mencegah bot merayapi tautan pada suatu halaman. Selanjutnya gunakan arahan nofollow di kode sumber halaman tersebut.

Perhatikan bahwa arahan noindex dan nofollow tidak kamu sertakan dalam file robots.txt. Tapi bisa kamu terapkan langsung pada halaman atau tautan dalam kode sumber.

Beberapa cara setting robot txt tadi bisa kamu perhatikan dalam rangka mengoptimasi SEO dengan memanfaatkan robots.txt. Langkah-langkahnya cukup mudah bukan? Semoga membantu dan ikuti terus update artikel terbaru seputar SEO di Blog Jagoan Hosting.